by drmunozcl

Share

Por drmunozcl

Compartir

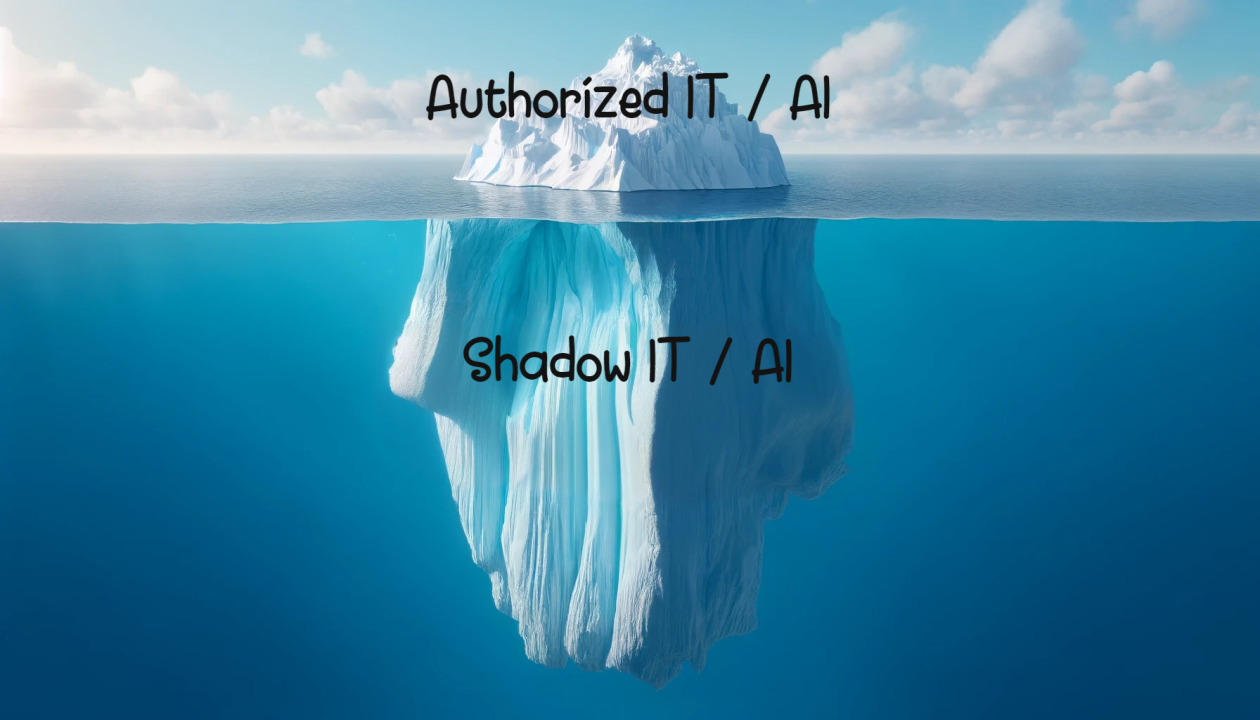

La adopción acelerada de la inteligencia artificial generativa está impulsando productividad, pero también abre una brecha silenciosa: Shadow AI. En ciberseguridad, este término describe el uso no autorizado o no gobernado de modelos de lenguaje (LLM), asistentes de código, agentes y APIs de IA por parte de equipos y usuarios, fuera del control de TI y Seguridad. El resultado es una superficie de ataque invisible que expone datos sensibles, debilita el cumplimiento y dificulta la respuesta a incidentes.

Definición técnica de Shadow AI

Shadow AI ocurre cuando empleados o áreas de negocio integran capacidades de IA sin pasar por procesos formales de evaluación y aprobación. Incluye:

- Uso de LLMs SaaS mediante web, plugins o extensiones de navegador.

- Consumo de APIs de proveedores de IA con claves propias y sin SSO ni CASB.

- Despliegue de modelos open source locales en laptops, servidores o contenedores con GPU.

- Integraciones improvisadas con RAG que consultan repositorios o bases de datos sin controles de acceso adecuados.

- Agentes que ejecutan herramientas en sistemas internos sin aislamiento ni auditoría.

Desde la perspectiva de arquitectura, Shadow AI introduce flujos de datos y ejecuciones que el SOC no observa: prompts con IP, PII o secretos que salen por HTTPs a dominios externos, librerías como openai, transformers o langchain integradas en servicios críticos, y notebooks que descargan modelos de repositorios públicos sin validación de integridad.

Riesgos de Shadow AI en ciberseguridad

Shadow AI en ciberseguridad amplifica riesgos ya conocidos del Shadow IT y añade vectores propios de la IA:

- Exfiltración de datos a terceros a través de prompts, archivos adjuntos o embeddings.

- Retención de datos por parte de proveedores y falta de garantías sobre su uso.

- Inyección de prompts desde contenido web o datos externos que induce acciones no deseadas.

- Alucinaciones con consecuencias de seguridad: configuraciones inseguras, código vulnerable o falsos hallazgos.

- Poisoning de modelos o datasets usados en fine-tuning y RAG, que introduce backdoors lógicos.

- Abuso de plugins y herramientas de agentes que operan con privilegios excesivos.

- Brechas de cumplimiento (PII, PCI, HIPAA, GDPR) por falta de DLP y trazabilidad.

- Costos impredecibles de tokens y consumo de GPU, que impiden una gestión eficaz de capacidad y presupuesto.

Modelo de amenazas y vectores de ataque

- Adversarios externos: explotan inyección de prompts en contenido público o cargas maliciosas para forzar al LLM a revelar secretos o ejecutar acciones vía agentes.

- Insiders negligentes: comparten datos sensibles con asistentes de IA, suben documentos a servicios no aprobados o integran APIs sin cifrado.

- Cadena de suministro de IA: modelos, checkpoints y datasets de repositorios públicos con malware, pesos manipulados o licencias inadecuadas.

- OAuth y plugins: aplicaciones de terceros con permisos amplios que acceden a correo, repositorios o calendarios sin supervisión.

- Integraciones RAG: fugas por índices mal segmentados, control de acceso laxo o URL signing ausente.

Indicadores de Shadow AI en ciberseguridad

Detectar Shadow AI requiere correlacionar red, endpoint, identidad y desarrollo:

- Tráfico saliente a dominios de LLMs y vectores de inferencia (por ejemplo,

api.openai.com,api.anthropic.com,generativelanguage.googleapis.com, Azure OpenAI, endpoints de Hugging Face o Replicate) desde hosts no autorizados. - Aparición de librerías

openai,anthropic,langchain,llama.cpp,transformersenrequirements.txt,package.json, Dockerfiles o lockfiles de proyectos. - Extensiones de navegador de IA instaladas masivamente y no aprobadas.

- Cargas GPU inusuales en estaciones de trabajo o VMs que antes no las registraban.

- Logs de proxy con altos volúmenes de peticiones y patrones de

User-Agentde SDKs de IA. - Claves de API de IA detectadas por escáneres de secretos en repositorios internos.

- Eventos de IAM que muestran aplicaciones OAuth con scopes sensibles relacionadas con IA.

Cómo abordar Shadow AI en ciberseguridad: controles prioritarios

- Definir política de uso de IA: establecer casos permitidos, datos prohibidos, proveedores aprobados, requisitos de cifrado y retención, y responsabilidades del negocio.

- Centralizar el acceso mediante un gateway de LLM: enrutar todo el tráfico de IA por un proxy con autenticación, registro, redactado de datos sensibles y control de costos por proyecto.

- Implementar DLP y egress filtering: inspeccionar prompts y adjuntos, bloquear PII, secretos y código propietario; restringir destinos a una allowlist de endpoints de IA.

- Aplicar un prompt firewall: sanitizar entradas, neutralizar inyecciones, imponer políticas de salida y validar funciones de agentes antes de su ejecución.

- Segmentar arquitecturas RAG: aislar índices por dominio de datos, aplicar control de acceso en consulta, cifrar embeddings y firmar URLs de acceso a documentos.

- Gestionar la cadena de suministro de modelos: usar un registro interno de modelos, verificar integridad de pesos, revisar licencias y escanear contenedores e imágenes de inferencia.

- Proteger secretos y claves: rotar y guardar claves de APIs de IA en un gestor de secretos; prohibir su uso directo en clientes; aplicar token exchange con expiración corta.

- Telemetría y auditoría de prompts: registrar prompts, adjuntos, respuestas y decisiones de agentes con hashing y retención definida para investigación y cumplimiento.

- Formación técnica al personal: entrenar a desarrolladores y analistas en riesgos de Shadow AI, redacción segura de prompts y patrones seguros de integración.

- Pruebas de seguridad dinámicas: ejecutar red teaming de prompts, simulaciones de inyección y evaluaciones de seguridad específicas para LLMs y agentes.

Arquitectura de referencia para reducir Shadow AI

Una arquitectura efectiva combina gobierno y controles técnicos:

- Identidad y acceso: SSO y MFA obligatorios para herramientas de IA; permisos por rol; consentimiento de aplicaciones OAuth con aprobación de seguridad.

- Pasarela de IA: proxy interno con policies de DLP, rate limiting, budget control, cifrado, masking de PII y reintentos controlados.

- Aislamiento de agentes y herramientas: sandboxes con permisos mínimos, ejecución sin acceso directo a internet y aprobación humana para operaciones sensibles.

- Datos y RAG: catálogo de datos, etiquetado de sensibilidad, índices separados por tenant y evaluaciones de leakage; uso de firmas y audit logs en recuperación.

- Observabilidad unificada: integración de logs del gateway, CASB, EDR, proxy y CI/CD en el SIEM con detecciones específicas de uso de IA.

- Ciclo de vida del modelo: registro, aprobación, evaluaciones de robustez, pruebas de jailbreak y control de versiones.

Con este diseño, el negocio utiliza IA de forma segura mientras el equipo de seguridad mantiene visibilidad, cumplimiento y control de costos.

Conclusión

Shadow AI representa una amenaza real porque oculta flujos de datos y capacidades de ejecución fuera del alcance de seguridad. Al definir políticas claras, centralizar el acceso mediante un gateway de LLM, reforzar DLP y egress, y profesionalizar RAG y agentes con aislamiento y auditoría, las organizaciones reducen riesgos sin frenar la innovación. La clave es transformar el uso espontáneo de IA en una plataforma gobernada, observable y medible. Así, Shadow AI en ciberseguridad deja de ser un punto ciego y se convierte en una ventaja competitiva gestionada.

MANTENTE INFORMADO

Suscríbete a nuestro newsletter gratuito.

La ciberseguridad ya no es una preocupación “a futuro”. Las amenazas que dominarán 2026 ya están ocurriendo hoy, afectando a empresas de todos los tamaños, sectores y regiones. Ataques más rápidos, automatizados y difíciles de detectar están redefiniendo la forma en que las organizaciones deben proteger su información. En este escenario, entender qué está cambiando

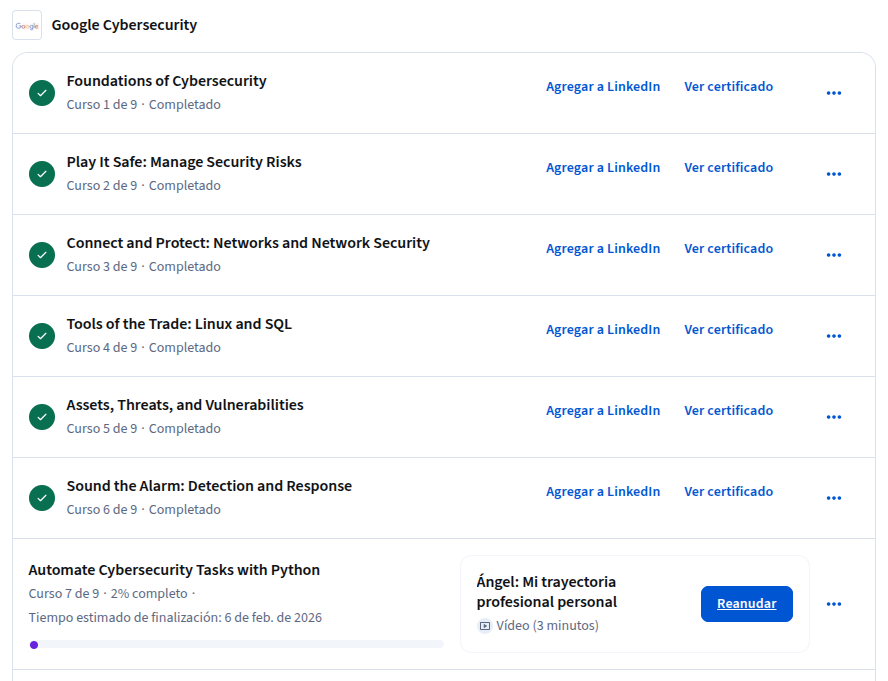

Durante las últimas semanas he estado un poco menos activo de lo habitual en el blog, y quería contarte el porqué de forma transparente. He estado completamente concentrado en obtener el Certificado Ciberseguridad de Google, impartido a través de Coursera. Es una certificación exigente, compuesto de 9 cursos, por lo que requiere tiempo, foco y

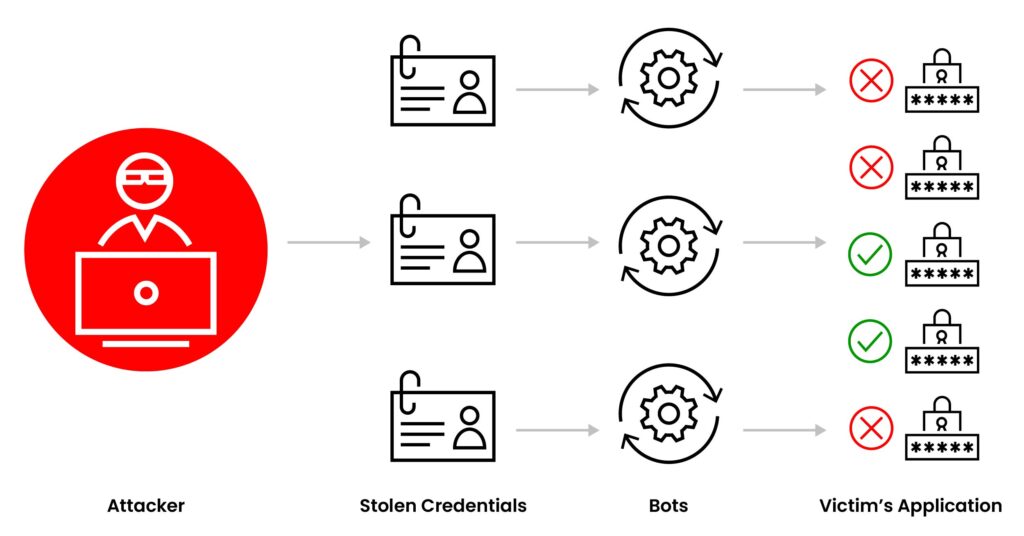

Te preguntas «¿Qué es Credential Stuffing?» Es un ataque automatizado donde delincuentes prueban, a gran escala, combinaciones de usuario y contraseña filtradas en otros servicios. Si un usuario reutiliza credenciales, el atacante accede sin necesidad de hackear el sistema. Spoiler: no son hackers con capucha adivinando contraseñas una por una, son bots probando miles por

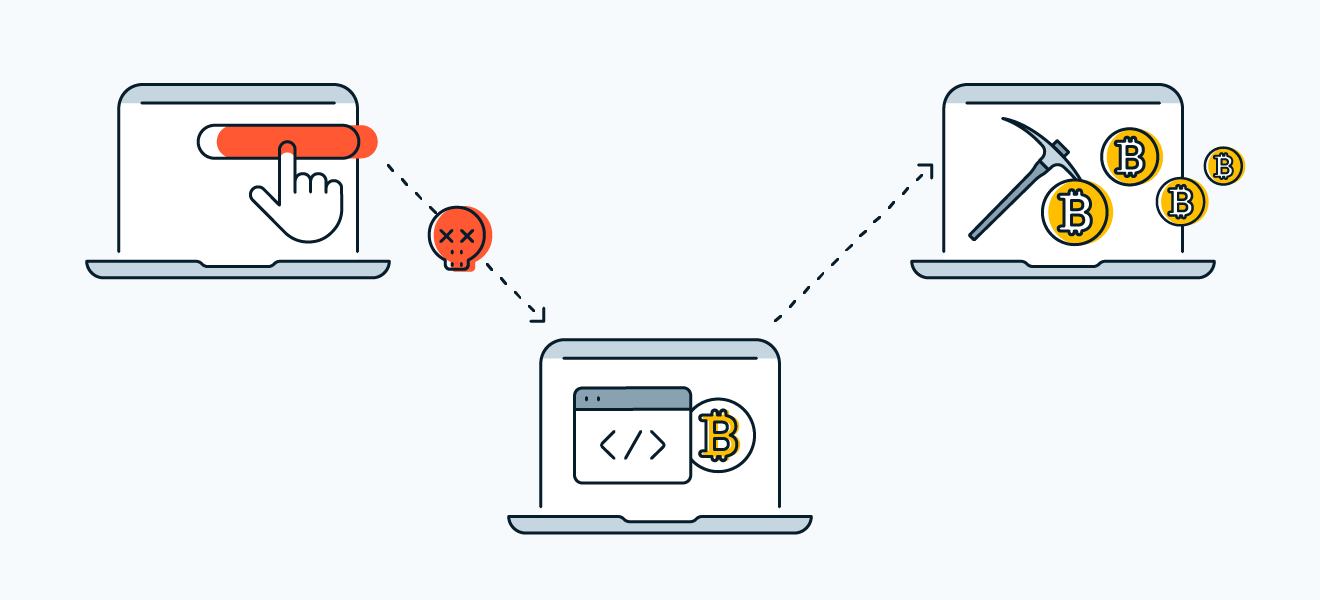

Si te preguntas qué es criptojacking, es el uso no autorizado de los recursos de cómputo (CPU/GPU, energía y red) de tus equipos o servidores para minar criptomonedas, generalmente Monero, por parte de atacantes. No roban datos directamente, pero exprimen tu infraestructura, encarecen la nube y reducen el rendimiento; si tu CPU suena como turbina