by drmunozcl

Share

Por drmunozcl

Compartir

La adopción de IA generativa avanza a gran velocidad, pero junto a la innovación llega un riesgo silencioso: el LLM Hacking. Este término describe el abuso o la manipulación de modelos de lenguaje (LLM) para provocar comportamientos no deseados o extraer información sensible. Si gestionas TI o lideras una pyme, tu mayor exposición no es solo técnica: también es humana. Compartimos datos con asistentes de IA como si fuesen parte del equipo… y no, el bot no firma NDA.

Ser precavido con la información que compartes no es paranoia; es una práctica de seguridad esencial. Muchas plataformas registran las interacciones para “mejorar el servicio”, algunos complementos amplían sin querer la superficie de ataque y un prompt malicioso puede forzar al modelo a ignorar instrucciones. El resultado: filtraciones de propiedad intelectual, datos personales y secretos de negocio que nunca debieron salir de tu perímetro.

LLM Hacking: qué es, cómo ocurre y por qué afecta a tu empresa

LLM Hacking engloba técnicas como la inyección de prompts (prompt injection), los jailbreaks, la exfiltración de datos a través de herramientas o integraciones, y la manipulación del contexto para forzar respuestas que vulneran políticas. No necesitas un adversario “hollywoodense”: basta un enlace malicioso, un archivo con instrucciones ocultas o una integración SaaS mal configurada.

- Inyección de prompts: un texto embebido en una página, documento o correo persuade al modelo para revelar instrucciones internas o datos del usuario.

- Jailbreaks: intentos de saltarse los guardarraíles para generar contenido o ejecutar acciones no permitidas.

- Fugas por integraciones: conectores, plugins o agentes que, sin controles, envían a terceros más información de la necesaria.

- Alucinaciones con confianza: el modelo «inventa» datos creíbles; si el equipo confía ciegamente, termina exponiendo o actuando sobre información errónea.

Consecuencias típicas: exposición de PII, secretos de API, contratos, roadmaps y código fuente; pérdidas reputacionales; y sanciones regulatorias (p. ej., RGPD). En pymes, el golpe es doble: menos recursos para contener la crisis y más dependencia de SaaS. En InfoProteccion vemos un patrón claro: el riesgo no aparece el día del ataque, sino el día que alguien pegó en el chat datos que nunca debieron salir.

Qué datos no deberías compartir con un LLM público

- Credenciales, claves API, tokens, secretos de cloud o VPN.

- Información financiera no publicada, ofertas comerciales y precios internos.

- Datos personales sensibles (propios o de clientes) y expedientes de RR. HH.

- Código propietario, diagramas de arquitectura y configuraciones de seguridad.

- Contratos, acuerdos de M&A y cualquier documento con cláusulas de confidencialidad.

- Incidentes de seguridad en curso o detalles forenses.

Si debes trabajar con estos insumos, usa entornos privados con controles, anonimiza o tokeniza, y limita el contexto a lo estrictamente necesario.

Buenas prácticas para reducir el riesgo de LLM Hacking

- Define una política de uso de IA. Especifica qué puede compartirse, con qué herramientas y bajo qué condiciones. Hazla breve y operativa.

- Activa controles de privacidad. En herramientas públicas, desactiva el uso de datos para entrenamiento cuando sea posible y ajusta la retención.

- Clasifica la información. Etiqueta datos (Público/Interno/Confidencial/Restringido) y alinea el uso de LLM según la etiqueta.

- Implementa un gateway de seguridad para IA. Aplica DLP, anonimización, filtrado de prompts/respuestas y registros centralizados.

- Minimiza el contexto. Proporciona al modelo solo los fragmentos necesarios; evita pegar documentos completos si bastan extractos.

- Protege secretos. Usa cofres de claves (secret managers) y evita exponer tokens en prompts, notebooks o capturas.

- Evalúa proveedores. Revisa ubicación de datos, cifrado, retención, auditorías, subprocesadores y opciones de segregación por tenant.

- Entrena al equipo. Simula inyección de prompts, refuerza el pensamiento crítico y enseña a reconocer señales de manipulación.

- Haz red teaming y pruebas de seguridad de IA. Evalúa jailbreaks, fugas de datos y comportamiento bajo entradas adversarias de forma controlada.

- Registra y monitorea. Activa auditoría de prompts y respuestas, integra con SIEM y establece alertas por contenido sensible.

Estas medidas combinan gobernanza, controles técnicos y cultura. Reducen superficie de ataque y, sobre todo, evitan que un descuido se convierta en titular.

Checklist rápida antes de presionar «Enviar»

- ¿Necesita el LLM este dato para resolver la tarea? Si no, elimínalo.

- ¿El texto contiene PII, secretos o cláusulas confidenciales? Redacta o anonimiza.

- ¿Estoy en un entorno con DLP y registros habilitados? Si no, cambia de canal.

- ¿El prompt podría ejecutarse a través de un plugin/agente no auditado? Desactívalo.

- ¿El proveedor puede usar mis datos para entrenar? Ajusta la configuración o busca alternativa.

Conclusión

El LLM Hacking no es ciencia ficción; es una amenaza práctica que crece al ritmo de la adopción. Ser precavido con lo que compartes y establecer controles claros protege a tu empresa de fugas costosas y decisiones mal informadas. Empieza por políticas sencillas, aplica mínimos de privacidad y construye sobre una base técnica sólida. Si necesitas acompañamiento para evaluar riesgos, seleccionar herramientas o diseñar un programa de seguridad de IA, en InfoProteccion podemos ayudarte a avanzar con velocidad y control. Innovar sí; improvisar, no.

MANTENTE INFORMADO

Suscríbete a nuestro newsletter gratuito.

La ciberseguridad ya no es una preocupación “a futuro”. Las amenazas que dominarán 2026 ya están ocurriendo hoy, afectando a empresas de todos los tamaños, sectores y regiones. Ataques más rápidos, automatizados y difíciles de detectar están redefiniendo la forma en que las organizaciones deben proteger su información. En este escenario, entender qué está cambiando

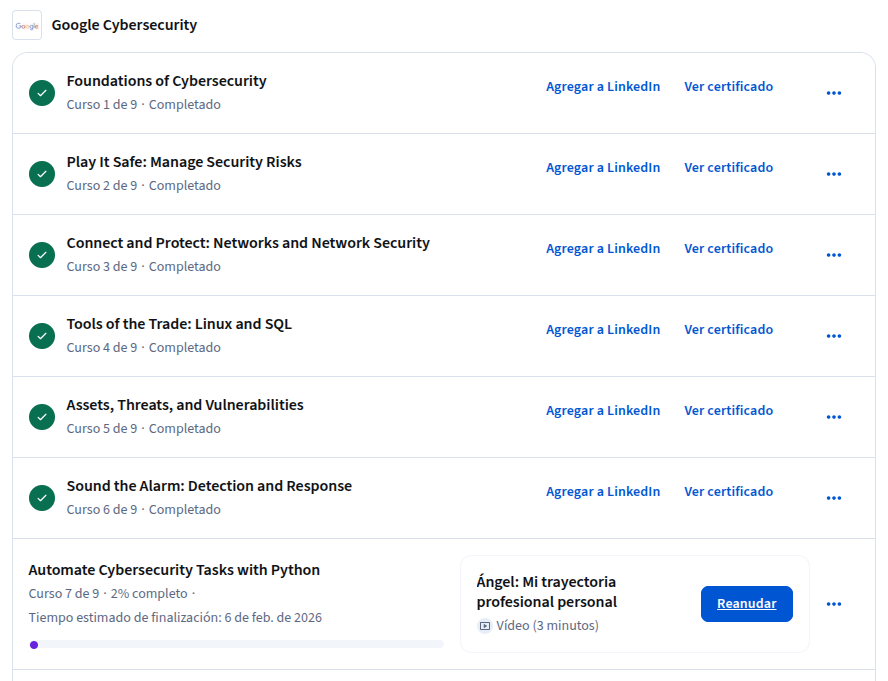

Durante las últimas semanas he estado un poco menos activo de lo habitual en el blog, y quería contarte el porqué de forma transparente. He estado completamente concentrado en obtener el Certificado Ciberseguridad de Google, impartido a través de Coursera. Es una certificación exigente, compuesto de 9 cursos, por lo que requiere tiempo, foco y

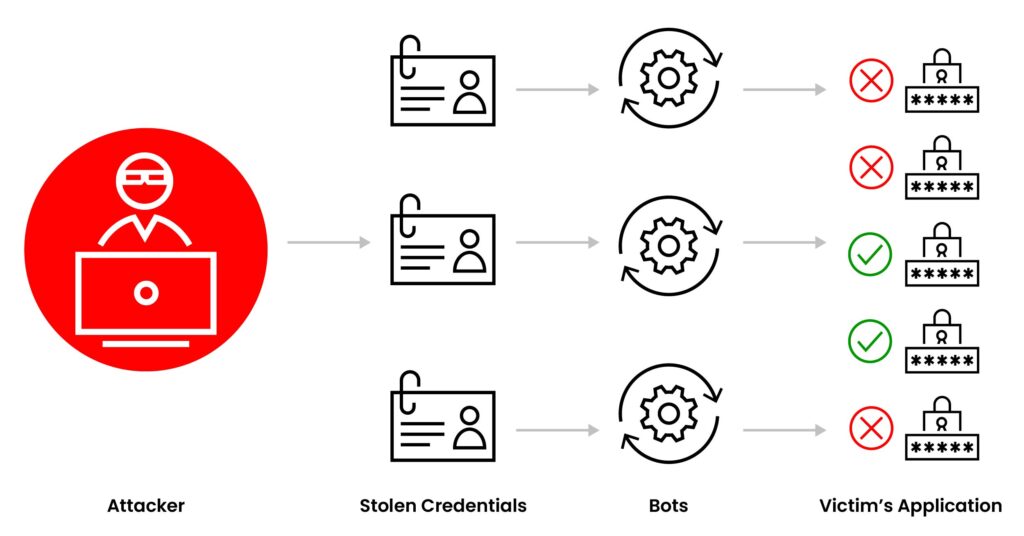

Te preguntas «¿Qué es Credential Stuffing?» Es un ataque automatizado donde delincuentes prueban, a gran escala, combinaciones de usuario y contraseña filtradas en otros servicios. Si un usuario reutiliza credenciales, el atacante accede sin necesidad de hackear el sistema. Spoiler: no son hackers con capucha adivinando contraseñas una por una, son bots probando miles por

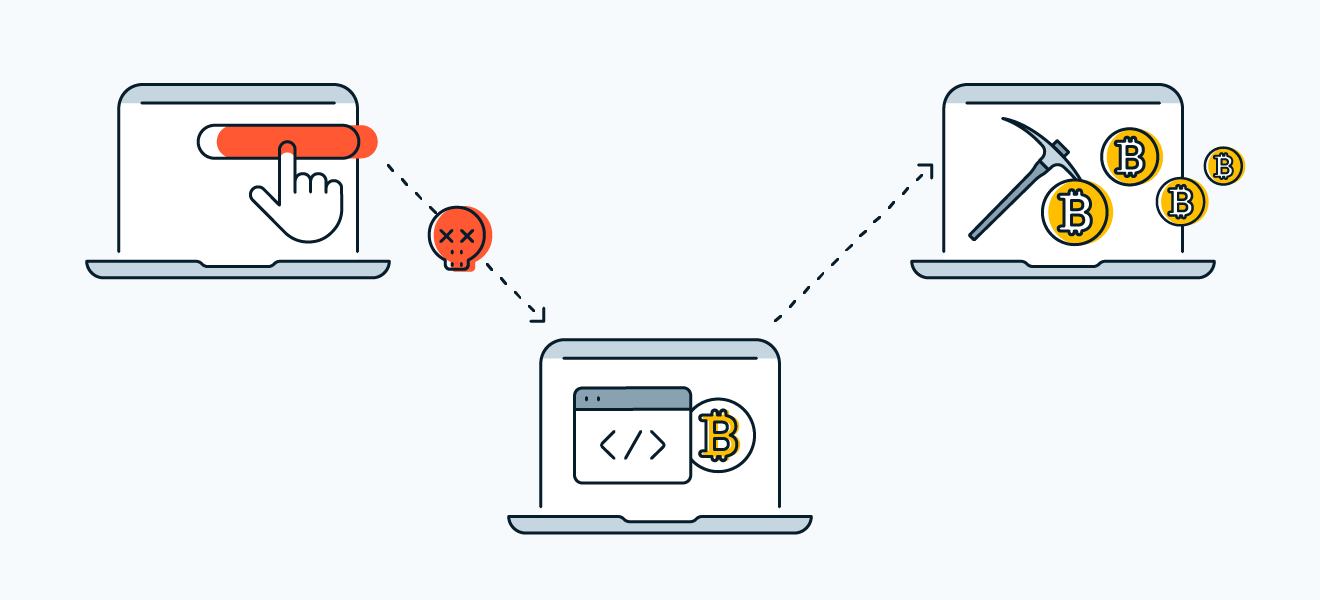

Si te preguntas qué es criptojacking, es el uso no autorizado de los recursos de cómputo (CPU/GPU, energía y red) de tus equipos o servidores para minar criptomonedas, generalmente Monero, por parte de atacantes. No roban datos directamente, pero exprimen tu infraestructura, encarecen la nube y reducen el rendimiento; si tu CPU suena como turbina